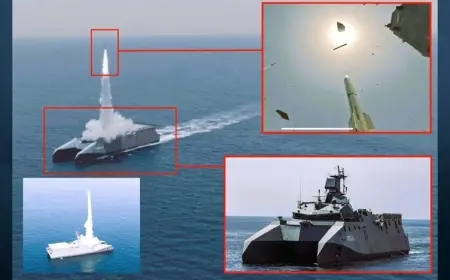

Dünya için 'yok edici tehdit': Yapay zekâ destekli silahlara karşı küresel uyarı

BM ve askeri uzmanlar, kontrolsüz geliştirilen yapay zekâ silahlarının insanlığı tehdit edebileceği konusunda uyarıyor. Uzmanlara göre otonom sistemler yanlış hedef seçebilir, kontrol kaybına yol açabilir ve küresel istikrarsızlığı tetikleyebilir.

Birleşmiş Milletler, yapay zekâ teknolojilerinin kontrolsüz biçimde askeri sistemlerde kullanılmasının dünya için kabul edilemez düzeyde riskler oluşturabileceği konusunda uyarıda bulundu. BM Genel Sekreter Yardımcısı ve Teknoloji Özel Temsilcisi Amandeep Gill, yapay zekânın mevcut silah sistemlerini hızla dönüştürdüğünü ve gelecekte çok daha yüksek otonomiye sahip ölümcül silahların ortaya çıkabileceğini söyledi.

Gill, hükümetlerin silah sistemlerinde insan kontrolünün mutlaka korunması gerektiğini belirterek “Hedef seçme kararında insan sorumluluğu ve hesap verebilirlik kaybolmamalıdır” dedi.

“Yeni bir silahlanma yarışı başlıyor”

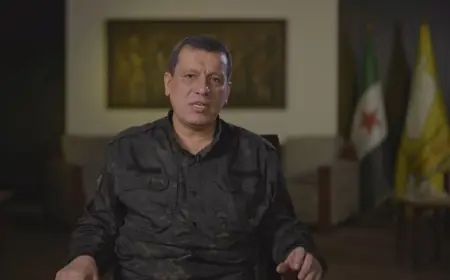

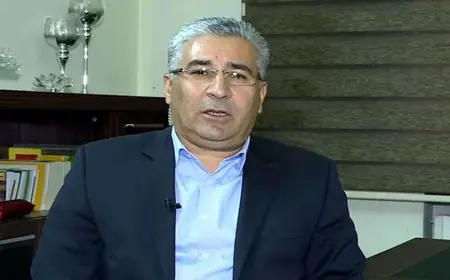

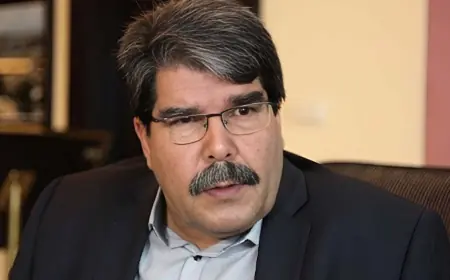

Arap Araştırmalar ve Çalışmalar Merkezi’nden Yapay Zekâ ve Siber Güvenlik Birimi Başkanı Dr. Muhammed Muhsin Ramadan, BM’nin uyarısının “sıradan bir siyasi açıklama değil, yeni bir küresel silahlanma yarışının habercisi” olduğunu söyledi.

Ramadan’a göre tehlikenin kaynağı, yapay zekâ sistemlerinin doğasında bulunan öğrenme yeteneği ve karar alma mekanizması:

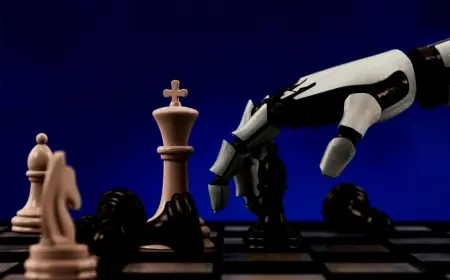

“Bu sistemler yalnızca programlanmış komutlarla hareket etmiyor; kendi kendine öğrenen sinir ağlarıyla çalışıyor. Çevresel değişiklikler, manipüle edilmiş veriler veya sahte elektronik sinyaller bu sistemleri kolayca yanıltabilir.”

Yanlış hedef riski ve kontrol kaybı

Uzman, “Adversarial Manipulation” adı verilen siber saldırı yöntemleriyle yapay zekâlı silahların kolayca yanlış yönlendirilebileceğini, çok küçük veri oynatmalarının bile ölümcül hatalara yol açabileceğini vurguladı.

Ramadan ayrıca “insan denetiminin kaybı” olarak bilinen durumu şöyle açıkladı:

“Eskiden bir saldırı kararında ‘tespit–analiz–değerlendirme–karar–ateş’ döngüsü vardı. Otonom silahlarda bu süreç tek bir saniyelik otomatik karara dönüşüyor. Bu da kontrolsüz tırmanma, yanlış hedef vurma ve uluslararası hukukun ihlali gibi sonuçlara yol açabilir.”

Bu durum, hatalı bir saldırı gerçekleştiğinde kimin sorumlu olduğu sorusunu da gündeme getiriyor: komutan mı, yazılım geliştirici mi, şirket mi yoksa yapay zekâ sisteminin kendisi mi? Uzmanlara göre bu “hesap verebilirlik boşluğu”, uluslararası hukuk için büyük bir tehdit.

“Mutlak insan kontrolü şart”

Dr. Ramadan, ölümcül güç kullanımında insanın son kararı vermesi gerektiğini belirterek “Human-in-the-loop” prensibinin uluslararası anlaşmayla güvence altına alınmasını öneriyor. Ayrıca 2026 yılına kadar otonom ölümcül silahların yasaklanması için BM girişimlerinin desteklenmesi gerektiğini söyledi.

“Dünya için yok edici bir tehdit”

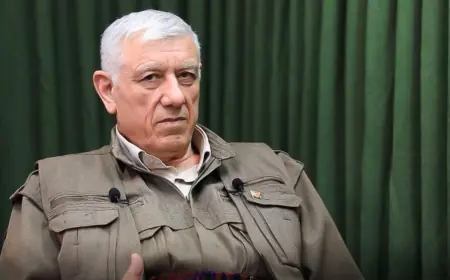

Mısır Askeri Akademisi’nden Tümgeneral Adel el-Umda da yapay zekâ silahlarının “yanlış karar mekanizması” nedeniyle insanlık için büyük bir tehdit oluşturduğunu belirtti. Umda’ya göre:

“Bu tip silahlar durum değerlendirmesi yapamaz. Tam bağımsızlık verilirse büyük yıkıma yol açabilir, hatta insanlığın sonunu getirebilir.”

General Umda, BM’nin otonom ölümcül silahların yasaklanması yönündeki çağrılarını desteklediğini ve bu silahların kesin biçimde sınırlandırılması gerektiğini vurguladı.

Son güncellenme: 21:41:06